NLP version : 2023.03.14 - [논문 정리] - PFMs for Natural Language Processing

Transformer

- self-attention 방법을 제안한 최초의 논문

- Encoder에선 sequence 를 vector로 encoding, Decoder에선 이를 auto-regressive 하게 각 단어에 대한 확률로 반환

- auto-regressive 한 Decoder로 인해 이전 또는 이후 정보만 사용하고, 이전-이후 정보를 동시에 사용할 수 없기 때문에 문맥에 대한 이해가 부족하다는 단점이 존재

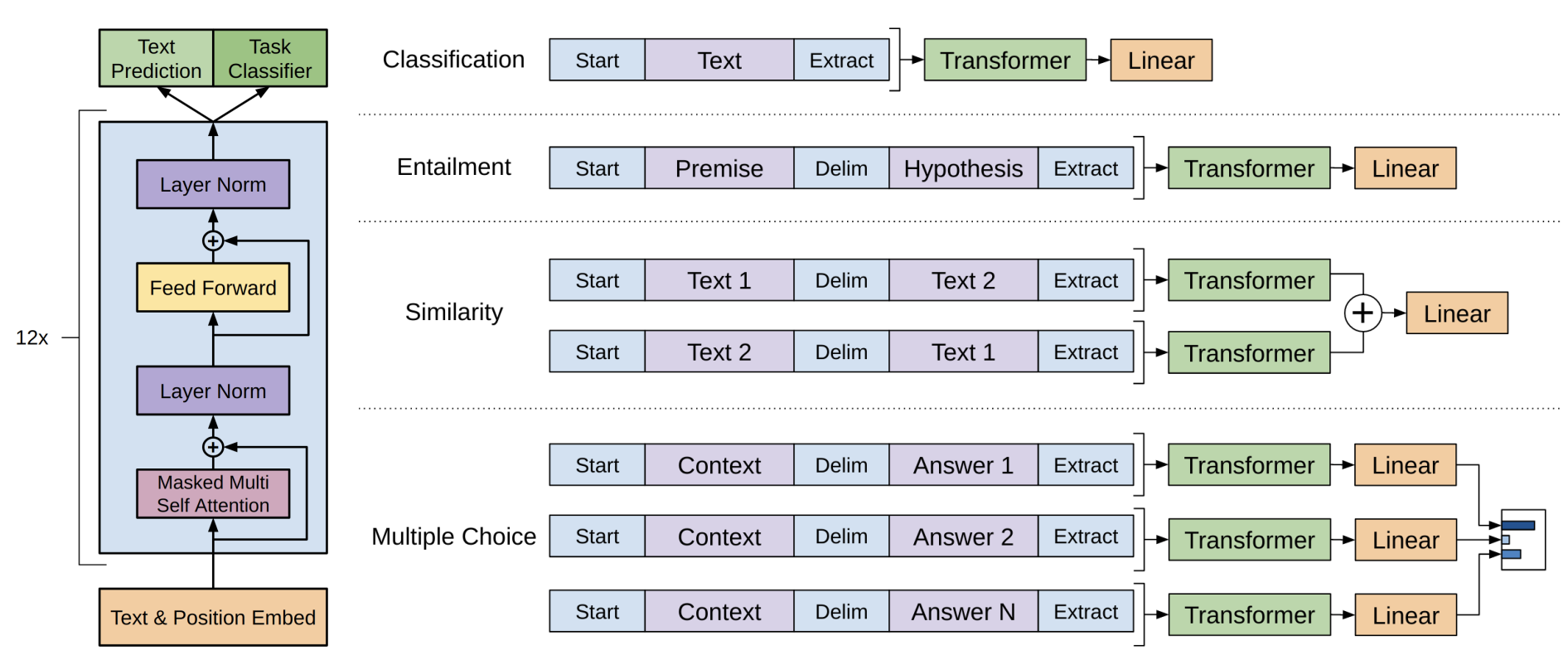

GPT & GPT-2

- Transformer Decoder를 12개 쌓음 (GPT-2 는 decoder를 48개로 쌓음)

- auto-regressive 방식

- self-supervised 및 supervised fine tuning 방식을 이용함

- GPT-2 에선 multi-task learning을 하는 방법 소개

- multi-task pretraining 과 super-large dataset, super-large 모델로 Transformer의 단점인 문맥 이해를 못하는 것을 극복

BERT

- Contextual LM

- Transformer Encoder를 feature extractor 로 사용

- Word-Peice tokenize 사용

- word embedding, segment embedding, potion embedding 으로 구성

- MLM (Masking LM) 사용하여 bi-directional 한 학습 구조 가지게함

- MLM : 어떤 단어를 masking 하여 이를 예측하고 두 문장이 문맥적으로 맞는지 판단

- NSP (Next Sentence Prediction) 사용하여 두 문장 간의 relationship 파악.

- bi-directional encoding으로 인해 놓친 token 들은 독립적으로 예측되어서 generation 능력 저하

- 많은 computing power 필요

- MLM 모델은 pretraining 동안만 masking 이 마킹되지 fine tunning 과정에선 되지 않아서 여전히 불일치 문제가 발생

ROBERTa

- contextual LM

- BERT에서 훈련시 많은 training task와 더 큰 corpus 가 필요한 점을 개선

- 더 큰 batch size와 unlabeled data 사용

- 더 오래 훈련

- NSP 제거

- full sentence에 대한 훈련 하여 순서를 학습하도록

- input sequence 마다 다른 masking 처리를 해주는 BPE (Byte Pair Encoding) 사용 . input sequence가 동시에 들어와도 다르게 처리

XLNET

- permuted LM = auto-regressive LM + contextual LM

- auto-regressive LM 과 달리 sequence를 순서대로 모델링하지 않고, sequence의 가능한 모든 순열 (permutation)을 제공

- 모든 위치에 있는 문맥 정보 파악 가능

- Transformer-XL 에 relative positional encoding 과 segment recurrence 결합

- segment recurrence를 통해 긴 문장에 대해서도 permutation을 계산할 수 있는 방법 고안

ELMO

- conceptual LM

- 오직 bi-LSTM 만 사용

- 양방향의 likelihood를 최대화 하는 목적으로 학습

- 문맥 정보를 도입하고, 다의어 문제를 개선

- 언어적 특징을 잘 추출하지 못함

BART

- encoding-decoding 구조의 seq2seq 모델로 noise를 줄인 auto-encoder 모델

- noise를 사용하여 text를 파괴한 뒤, seq2seq 모델로 텍스트 재구성

- noise 의 종류 : single word mask, word deletion, span mask, sentence rearrangement, document rearrangement

- encoder엔 masking 되어서 들어가고 decoder는 이를 복구하는 방식

- BERT Encoder (\(\sim\) Transformer Encoder), GPT Decoder

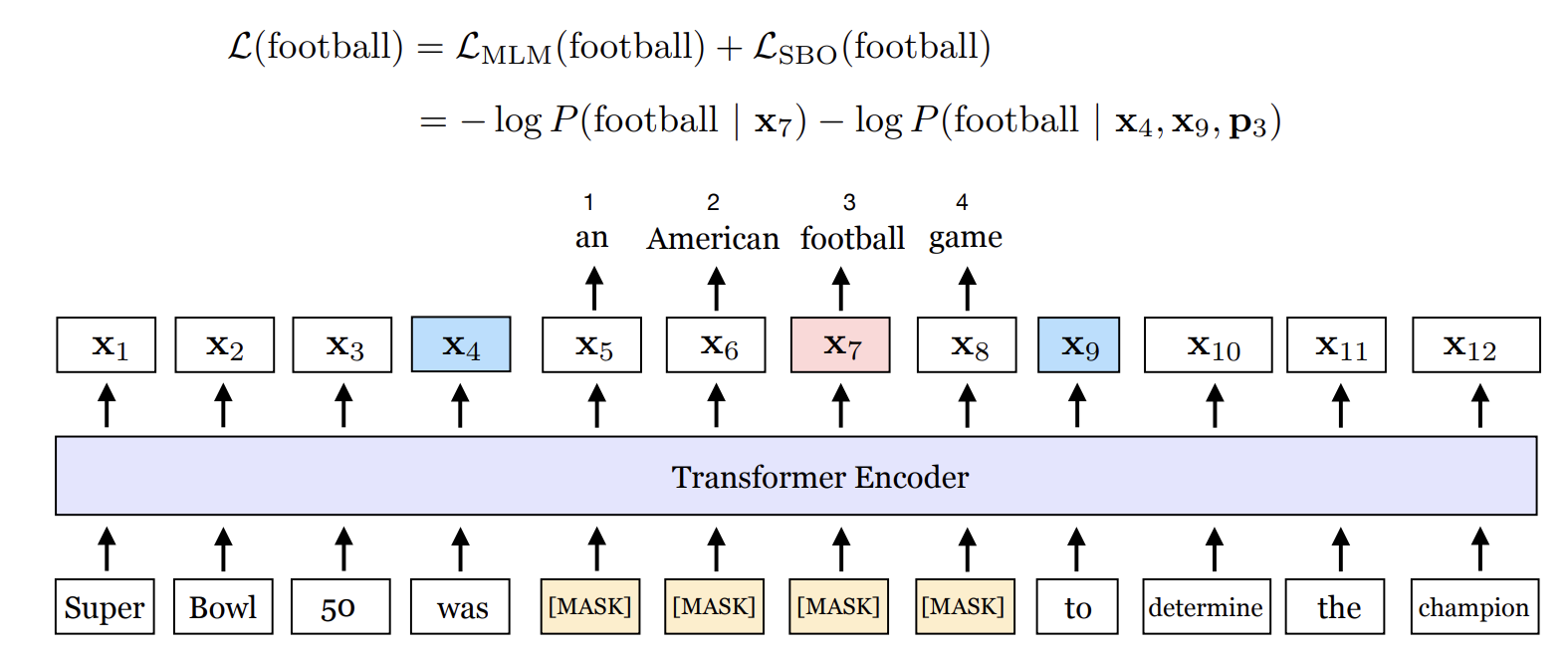

SpanBERT

- RoBERTa 기반

- dynamic masking , single segment pretraining

- SBO (Span Boundary Objective) 로 연속된 여러 단어를 masking

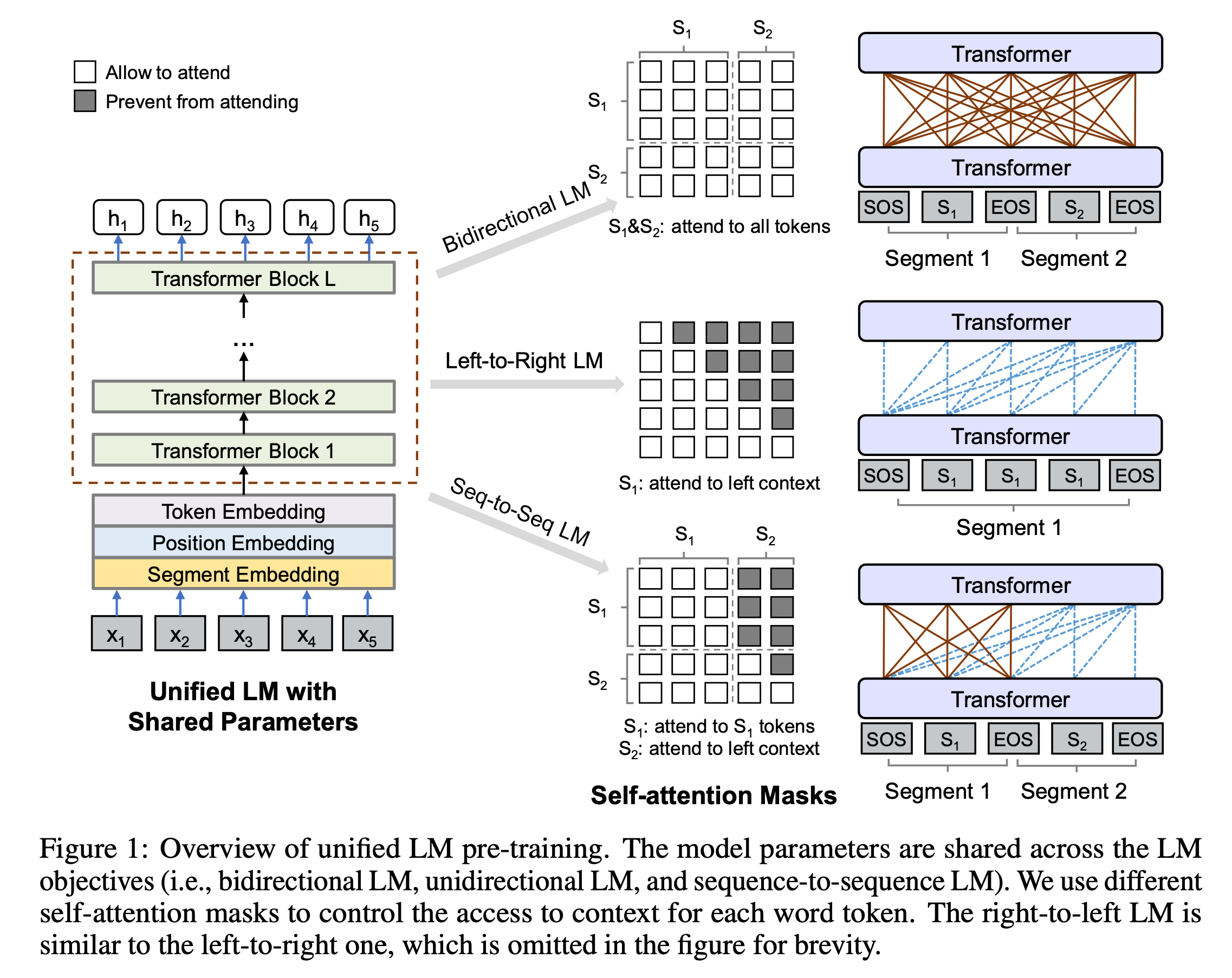

UniLM

- 두 문장 간의 다른 mask를 씌움

- 첫번째 문장에선 Transformer Encoder를 사용하여 각 단어가 앞뒤 단어를 알 수 있도록

- 두번째 문장에선 각 단어는 첫번째 문장의 모든 단어와 문장의 앞 단어만 인식할수 있도록

ERNIE & ERNIE 2.0

- Transformer Encoder와 task embedding part로 나뉨

- Transformer Encoder에선 self-attention을 통해 각 토큰에 대한 context 정보 추출 , context representation을 ㅇ,ㅁ베딩 하는 용도

- task embedding 에선 다른 task 들의 특성을 적용하는 방식

- ERNIE 2.0 에선 7개의 다른 task를 사용하여 word/ sentence/ semantic level 을 포함.

- continual learning으로 이전에 학습한 정보들을 유지하고 long distance memory 를 유지하게 함

'논문 정리' 카테고리의 다른 글

| Towards Adversarially Robust Object Detection (0) | 2023.03.16 |

|---|---|

| Benchmarking Robustness in Object Detection: Autonomous Driving when Winter is Coming (0) | 2023.03.16 |

| PFMs for Natural Language Processing (0) | 2023.03.14 |

| [Task 파악] Phrase Grounding & Weakly Supervised learning (0) | 2022.11.10 |

| Denoising Diffusion Probabilistic Models(DDPM) (1) | 2022.11.08 |

댓글