https://arxiv.org/pdf/2006.16241.pdf

Abstract

4개의 real-world distribution을 가진 dataset을 공개 : change image style , image blurriness, geographic location, camera operation, etc.

이러한 새로운 데이터셋으로 robustness를 위한 견고성을 개선하기 위한 방법을 테스트.

그 결과 larger model을 사용할수록 artificial data augmentations이 real-world distribution에서 robustness 하다는 것을 발견하였다. 데이터 증강이 효과가 있다는 것에 아이디어를 얻어 1000 배 더 많은 데이터로 pretrained 된 모델을 능가하는 새로운 data augmentation 방법을 소개한다.

그러나 지리적 변화와 같은 곳에서는 도움이 되지 않는 다는 것을 발견하여 일관적으로 robustness를 향상시킨다는 것을 보여준다. 그래서 future work은 동시에 여러 분포의 변화를 연구해야한다.

Introduction

motivation은 생략.

ImageNet-Renditions (ImageNet - R) 소개. 3만장의 vairous renditions (e.g. 그림, 자수)이 있는 test set. 이러한 렌더링은 ImageNet 이미지와 달리 texture와 local image 통계가 자연스럽게 발생하므로 synthetic robustness 벤치마크에서 얻는 gain 과 함께 비교가 가능하다.

다음으로 본 논문에선 StreetView StoreFornts(STSF)와 DeepFashion Remixed로 이미지 capture process의 효과 변화를 조사한다 SVSF 와 DFR 은 모두 distribution shift control을 제공하며 texture 를 변경하지 않아 이전 benchmark에 영향을 미칠 수 있는 가능한 confounding variable를 제거한다.

추가로 ImageNet의 100개의 class 에 대한 natural blur image를 100개의 이미지 Real Blurry Image를 수집하였다. 이 이미지는 ImageNet-C 벤치마크에서 synthetic blur에 대한 대체제로 사용한다.

마지막으로, DeepArgument를 제공하여 새로운 distribution shift 에 대한 robustness를 향상시킨다. 다른 augmentation 방법과 결합하여 1000 배 더 많은 label 된 데이터를 사용하여 pretrained 된 모델보다 더 높은 성능을 발휘할 수 있게한다.

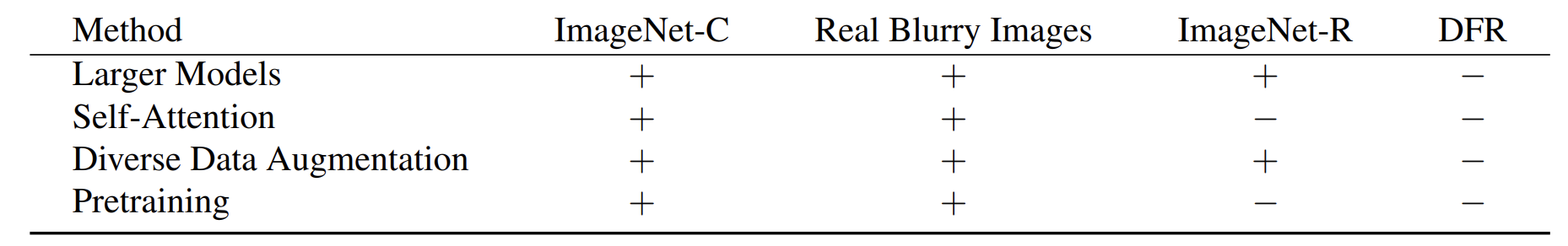

본 논문에선 이러한 새로운 데이터셋을 사용하여 robustness를 향상시키는 4가지 방법을 테스트한다.

- Larger Models : model size를 증가시켜 distribution shift 에 대한 강건성을 향상시킨다.

- Self - Attention: self-attention layer 를 추가 시켜 model robustness를 향상시킨다.

- Diverse Data Augmentation : data augmentation 을 통해 robustness를 향상

- Pretraining : 큰 모델과 다양한 데이터셋을 pretraining 하여 robustness를 향상

New Datasets

ImageNet-R

다양한 추상적인 시각적 표현애 데한 genralization 을 측정하기 위해 ImageNet-R 을 만들었다. ImageNet-R은 다양한 artistic rendition을 포함한다.

Data Collection

ImageNet-R은 3만장의 이미지로 200 개의 class를 가지고 있다. ImageNet에서 일부 클래스들은 이미 "triceratops"와 같이 많은 rendering을 갖고 있고, label noise를 줄이기 위해 subset을 선택한다. 즉, 헷갈릴 수 있는 label은 제외하고 선택한 것이다. ImageNet-R은 "art" "cartoon", 등과 같은 쿼리로 선택하여 이미지를 수집하였다.

StreetView StoreFronts (SVSF)

Google Street View 이미지에서 샘플링 된 이미지를 수집한다. 주로 country,year, camera 에 세가지 distribution shift 에 초점을 맞추고 있다.

Data Collection

SVSF는 object detection model에 의해 crop 된 이미지로 StreetView에서 추출된 가게 앞면 이미지를 포함한다. 이 때, visual이 비슷한 것 ( drug store and pharmacy)들을 결합하여 총 20 개의 class로 만들었다. 그리고 이미지의 속성으로 camera, year, country를 추가하였다.

DeepFashion Remixed

일상적인 카메라의 변동은 object size나 object occlusion, camera veiwpoint , camera zoom 과 같은 속성들의 변화를 야기한다. 따라서 이를 측정하기 위한 데이터셋을 구축하였다. 이는 DeepFashion2 를 변화한 DeepFashion Remixed 를 재제안한다. 48K 의 trianing set을 구축하고 object size, object occlusion, camera viewpoint, camera zoom -in 의 성능 변화를 측정하기 위해 8가지의 OOD test set을 구축하였다. 그리고 이는 multi-label classficiation task 용으로 되어 있다.

Data Collection

SVSF 와 비슷하게 training distribution에서 각 4개의 메타데이터 속성에 대해 하나의 값을 고정하였다. 즉, training set에선 medium size, medium occlusion, side/back viewpoint, and no zoom-in 의 속성을 포함한다. 그리고 test set에선 최소 및 심한 가려짐, 작은 및 큰 크기, 정면 및 미착용 시점, 중간 및 큰 줌인을 갖는 테스트 세트를 얻기 위해 여덟 개의 OOD 테스트 분포를 구성 한다.

Real Blurry Image

1000 개의 real-world blurry image를 수집하여 ImageNet-C의 blur 이미지로 대체한다.

DeepAugment

새로운 Image Augment 전략을 소개. (기존에 있는 DeepAugment 랑 다른 것)

DeepAugment 는 clean 이미지를 image-to-image network를 통과하면서 동작되고, perturbation을 입힌다. 이러한 perturbation은 랜덤하게 샘플링되고, network forward 할 때, weight에 적용된다. perturbation의 종류로는 zeroing, negating, convolving, transposing, activation function 적용 등이 있다. 비록 random 하게 적용됐을 지라고 ImageNet-C와 ImageNet-R에서 좋은 성능을 보인다.

AutoEncoder 구조를 가지는 CAE architecutre 와 super resolution arhictecutre를 가지는 EDSR 를 사용한다.

Experiments

Model Architecture and Size : baseline : Resnet-50, largeer model : ResNeXtx , ResNet-152

Pretraining : 약 21,000 개의 class 와 14 million label이 지정된 training 이미지, 즉 ImageNet-1k 의 10배에 해당되는 데이터셋 사용. ResNeXt-101 모델 사용

Self-Attention : CBAM 과 SE 모듈 사용

Data Augmentation : Style Transfer (SIN), AugMix, DeepAugment 사용. Speckle Noise 와 adversarial noise와 비교

Results and Conclusion

Larger model : ImageNet-C 와 ImageNet-R 에서 강력, 하지만 DFR 에선 별루

self-attention : ImageNet-C 에서 도움되었지만 ImageNet-R 과 DFR 에선 별 도움 안됨.

Image Augmentation : ImageNet-C 에선 큰 향상을 이뤘지만 SVSF 나 DFR 에선 별 도움 안됨

Pretraining : ImageNet-C에선 큰 도움이었지만 DFR 이나 ImageNet-R에 대해선 별 도움 안됨.

댓글