https://arxiv.org/pdf/2303.08622.pdf

Contribution

- Zero-shot style transfer model 제안함

- 이를 위한 zero-shot contrastive loss 를 제안함

Overview of Proposed Method

DDIM 으로 Forward 하고, Reverse 과정에서 DDPM을 사용. 그리고 Reverse 중간중간에 CLIP loss와 ZeCon loss를 추가해주면서 Style과 Content 에 대한 학습을 이룸. main contribution 중 하나는 추가적은 training 없이, guide 가 가능하다는 것이다.

이 때, CLIP으로 Style 을 guide 하고, ZeCon으로 content를 guide 함

Style Guide loss

zero-shot 이기 때문에 CLIP loss 를 기반으로 한다.

식은 다음과 같다.

여기서 \( l_{global}\) 은 styleclip의 loss 를 사용해서 diffusion 의 latent image와 style text 간의 cosine similiarity를 구한다. 그리고 \( l_{dir}\) 은 CLIP embedding space에서 mode collapse 와 corrupted image quality 때문에 발생하는 문제를 해결하기 위해 추가한 항으로 다음과 같은 식으로 이루어진다.

\( \Delta I \)는 latent image 와 input 이미지의 차이를 의미하고, \( \Delta T \)는 target text 와 source text 의 embedding 차이를 의미한다. 따라서 이는 cosine similiarity 2개가 합쳐진 것을 의미한다.

Content Preservation loss

Content 를 보존하기 위해 CUT loss 와 VGG perception loss 와 MSE loss를 더한 것이다.

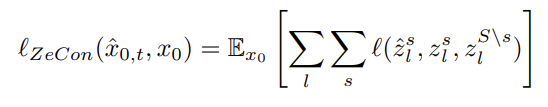

pathNCEloss (called ZeCon)는

z는 l 번째 layer의 layer feature 이다. 그리고 VGG loss (perceptual loss) 이고, 그리고 MSE loss 를 더한다.

## Not Additional Training

본 논문은 additional training 이 없고, loss로만 guide를 주는 것이 핵심이다.

diffusion 모델의 unet noise predictor가 spatial information을 기존에 입증이 되었기 때문에, 추가적인 training 없이 각 latent image와 guide 이미지 만의 loss 계산으로 guide를 줄 수 있다는 것이 핵심이다.

댓글